“Una volta sola”: come l’interoperabilità nel cloud cambia i servizi pubblici

Cloud e interoperabilità alimentano il dialogo tra piattaforme, dati e applicazioni per semplificare la vita di cittadini e imprese

di Claudio Cocciatelli, Daniele Pizzolli, Matteo Fortini, Rocco Affinito e Fabrizio De Rosa, Dipartimento per la trasformazione digitale della Presidenza del Consiglio dei ministri

L'attuazione del Piano Nazionale di Ripresa e Resilienza (PNRR) sta accelerando il percorso di trasformazione digitale della Pubblica Amministrazione italiana rendendo l'accesso ai servizi pubblici più semplice e immediato.

L'interoperabilità tra sistemi informativi e servizi erogati in cloud rappresenta il vero motore dell'innovazione: solo favorendo il dialogo tra piattaforme, dati e applicazioni è possibile offrire ai cittadini e alle imprese servizi digitali integrati, moderni e utili per semplificare le loro vite.

Ma cosa significa davvero “interoperabilità” nel contesto della PA? Quali sono le sfide, le opportunità e le soluzioni già disponibili? E come si inserisce tutto questo nel quadro normativo e strategico nazionale ed europeo?

L'interoperabilità, nel settore pubblico, è la capacità dei sistemi informatici di enti diversi di “dialogare tra loro”, scambiando dati e informazioni in modo fluido, sicuro e standardizzato favorendo l'allineamento tra processi, politiche e obiettivi aziendali nel rispetto delle normative e degli accordi tra amministrazioni.

In pratica, interoperabilità significa abbattere i silos informativi e permettere a piattaforme diverse di integrarsi senza costose personalizzazioni o barriere tecniche. I cittadini potranno apprezzare l'interoperabilità dei sistemi quando non riceveranno più richieste di completare moduli e dichiarazioni con dati già in possesso della PA secondo quanto indicato dal principio europeo del “once only”, ovvero “una volta sola”. In altre parole, quando la Pubblica Amministrazione chiederà a cittadini e imprese i dati solo una volta, evitando richieste duplicate.

Il cloud computing è uno strumento chiave per la digitalizzazione della PA. La migrazione di servizi pubblici in cloud favorisce maggiormente l'interoperabilità degli stessi, ovvero l'integrazione di dati e applicazioni, anche di fornitori diversi.

Questo approccio virtuoso consente di evitare il “vendor lock-in”, favorisce la scalabilità, aumentandone la sicurezza e garantendone la continuità operativa. L'interoperabilità permette inoltre di sviluppare servizi pubblici “by design”, pensati fin dall'inizio per essere integrati e condivisi tra amministrazioni, cittadini e imprese.

Questo articolo intende offrire una panoramica su:

- il contesto normativo e strategico dell'interoperabilità nella PA italiana;,

- i principi chiave e i vantaggi;

- le tecnologie abilitanti e le piattaforme disponibili;

- le sfide di sicurezza e compliance;

- le prospettive future in un ecosistema sempre più orientato al cloud e all'innovazione.

Cosa intendiamo per interoperabilità?

L'interoperabilità rappresenta la capacità di diversi sistemi, piattaforme e applicazioni di comunicare, scambiarsi dati e utilizzare reciprocamente le funzionalità in modo trasparente, indipendentemente dal fornitore o dalla tecnologia sottostante.

Per esempio, nell'ottica degli sviluppatori software, non si deve usare un particolare sistema operativo, un particolare browser o un particolare editor di documenti per poter dialogare con la controparte. Questa caratteristica è fondamentale in un contesto in cui le organizzazioni adottano strategie multi-cloud o cloud ibridi, combinando servizi di diversi provider.

Le dimensioni principali dell'interoperabilità sono:

- tecnica, che riguarda la compatibilità tra protocolli, API e formati di dati;

- semantica, che assicura che le informazioni scambiate siano comprese allo stesso modo da tutti i sistemi coinvolti;

- organizzativa, che implica l'allineamento tra processi, politiche e obiettivi aziendali;

- legale: rispetto delle normative e degli accordi tra amministrazioni.

Un' elevata interoperabilità consente maggiore flessibilità e favorisce l'innovazione, rendendo più semplice l'integrazione di nuovi servizi e la collaborazione tra partner diversi.

Esempi di interoperabilità in Italia

L'Italia ha già avviato numerose iniziative che dimostrano il valore dell'interoperabilità:

- Fascicolo Sanitario Elettronico (FSE): consente la condivisione dei dati sanitari tra regioni e strutture sanitarie, migliorando la continuità delle cure;

- Anagrafe Nazionale Popolazione Residente (ANPR): gestisce e verifica automaticamente le informazioni anagrafiche dei cittadini;

- PagoPA: piattaforma nazionale per i pagamenti digitali verso la PA, integrata con i sistemi contabili degli enti;

- Sistema di eProcurement: consente l'acquisto di beni e servizi da parte delle PA in modo trasparente e interoperabile;

- ANIS (Anagrafe Nazionale dell'Istruzione Superiore): raccoglie e armonizza i dati delle iscrizioni e dei titoli degli studenti universitari da tutte le Università e gli AFAM (Istituti di Alta Formazione Artistica, Musicale e coreutica) a livello nazionale.

- Anagrafe Tributaria: banca dati nazionale gestita dall' Agenzia delle Entrate che raccoglie, organizza ed elabora tutte le informazioni relative alla fiscalità dei contribuenti italiani, ovvero persone fisiche, società, enti e associazioni

Il contesto normativo e strategico

In Italia, le organizzazioni pubbliche e private beneficiano di sistemi evoluti di gestione dell'interoperabilità. Come tutte le iniziative guidate dal Dipartimento per la trasformazione digitale della Presidenza del Consiglio dei ministri, la Strategia Cloud Italia promuove infrastrutture moderne, sicure e interoperabili in conformità alle normative nazionali e comunitarie, di seguito sono riportate quelle principali:

- Il Piano Triennale per l'Informatica nella PA 2024—2026, con l'aggiornamento 2025, rappresenta la bussola per la digitalizzazione pubblica. Il Piano pone l'interoperabilità come principio trasversale a tutte le componenti tecnologiche: servizi, piattaforme, dati, infrastrutture e sicurezza. Le PA sono chiamate a progettare e realizzare servizi “API-first”, interoperabili by design (cioè fin dalla progettazione) e by default (cioè in maniera predefinita) contestualmente alle modalità di accesso tradizionali orientate all'interazione con l'utente (per esempio tramite un sito web), accessibili tramite identità digitale e orientati all'utente, secondo il paradigma “once only”.

- L' Agenzia per l'Italia Digitale (AgID) ha adottato il nuovo Modello di Interoperabilità, sviluppato in collaborazione con il Dipartimento per la trasformazione digitale, che permette la collaborazione tra PA e soggetti terzi tramite soluzioni tecnologiche aperte e standardizzate, evitando integrazioni ad hoc e facilitando lo sviluppo di nuove applicazioni. Le Linee Guida AgID definiscono le regole tecniche, i protocolli di sicurezza e i criteri per l'uso delle API, in coerenza con l'European Interoperability Framework.

- Il Regolamento dell'Agenzia per la Cybersicurezza Nazionale (ACN) stabilisce i requisiti di sicurezza, affidabilità e qualificazione delle infrastrutture cloud per la PA. L'obiettivo è garantire che i servizi cloud siano interoperabili, resilienti e conformi alle normative italiane ed europee, riducendo il rischio di dipendenza da singoli fornitori.

- La protezione dei dati personali (GDPR) e la sicurezza delle reti e dei sistemi informativi (NIS2) sono pilastri imprescindibili. L'interoperabilità deve essere progettata “by design” e “by default” per garantire privacy, sicurezza e trasparenza nell'accesso e nello scambio dei dati.

Press enter or click to view image in full size

Interazioni macchina-macchina (M2M) nel cloud

Cosa sono le interazioni macchina-macchina e perché sono fondamentali nell'ecosistema cloud?

Le interazioni macchina-macchina (M2M) si riferiscono allo scambio automatico di dati tra sistemi informatici, senza intervento umano. Nell'ambito della PA, questo significa che due o più servizi digitali possono comunicare tra loro in tempo reale, ad esempio per aggiornare un'anagrafica (ad es. la residenza), verificare un pagamento (ad es. di un tributo) o accertare un requisito (ad es. l'ISEE).

Nel contesto cloud, le interazioni M2M sono fondamentali perché:

- automatizzano i processi tra enti diversi;

- riducono gli errori manuali e i tempi di attesa;

- favoriscono l'integrazione tra servizi distribuiti, anche su infrastrutture diverse (multi-cloud).

Le API (Application Programming Interface) sono gli strumenti principali per abilitare le interazioni M2M. Possiamo immaginarle come “contratti digitali” che definiscono:

- quali dati possono essere richiesti o inviati;

- in che formato;

- con quali regole di sicurezza e autorizzazione.

Nel Modello di Interoperabilità nazionale, le API devono essere:

- documentate e pubblicate nel catalogo della Piattaforma Digitale Nazionale Dati (PDND);

- sicure, tramite protocolli come HTTPS e tramite meccanismi di autenticazione (es. SPID, CIE, API Key);

- standardizzate, per garantire la compatibilità tra sistemi diversi.

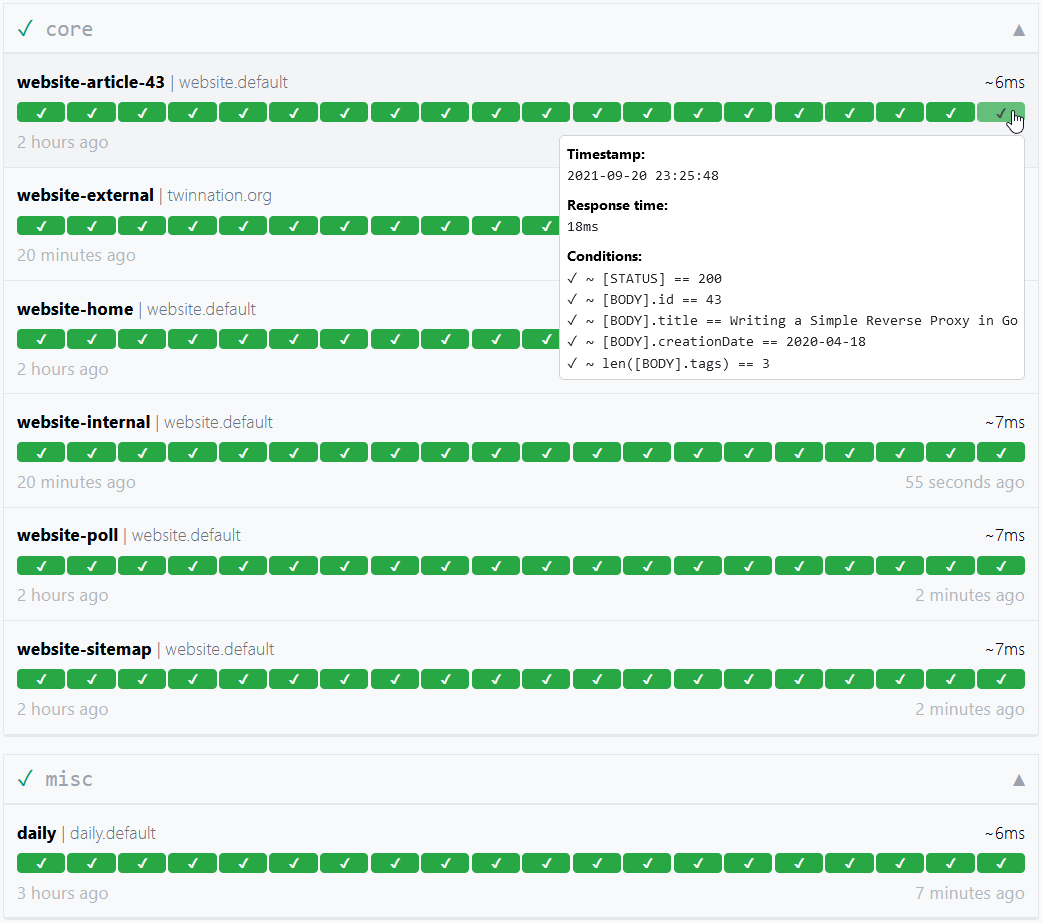

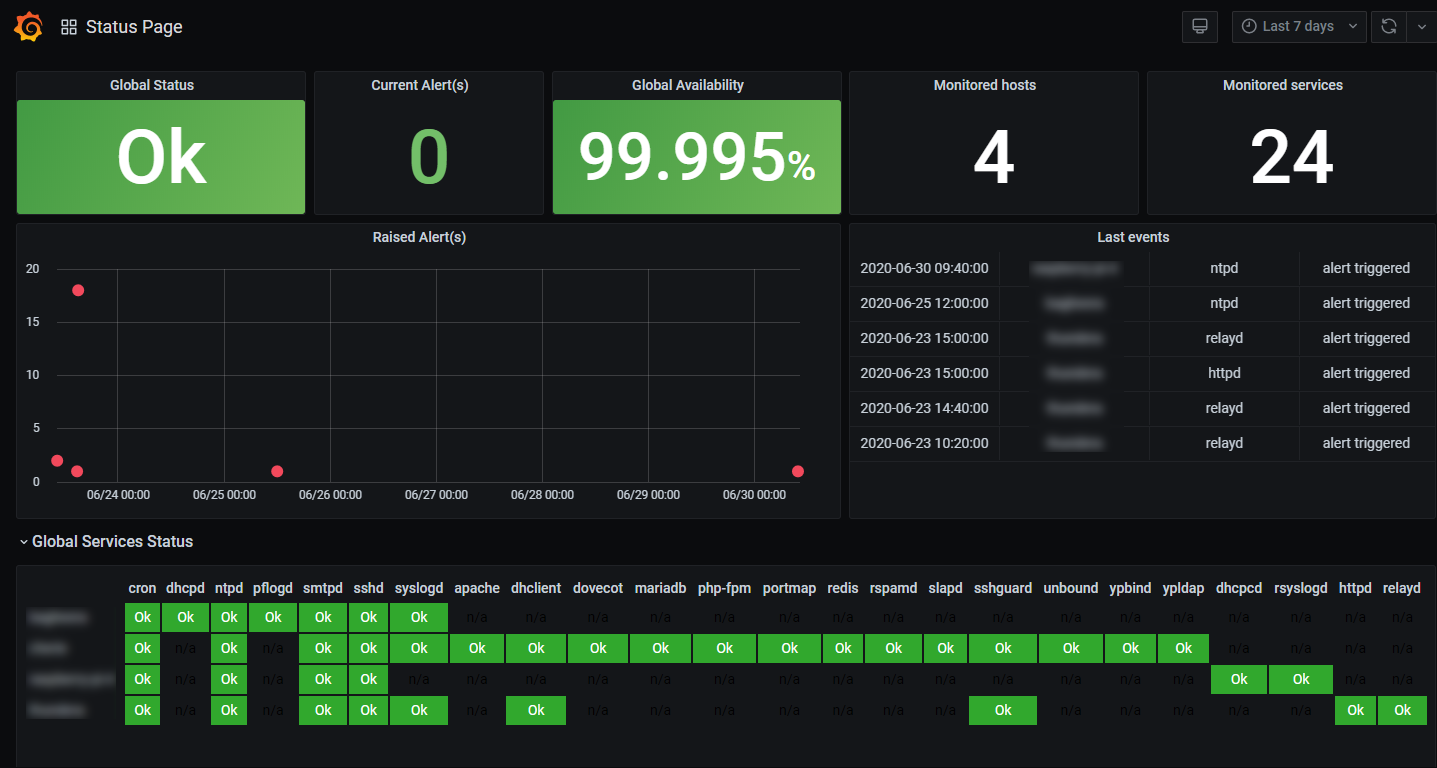

Un ecosistema interoperabile richiede una governance chiara delle API, che includa:

- ruoli e responsabilità (es. API owner, sviluppatori, auditor);

- politiche di gestione delle versioni e deprecazione;

- monitoraggio delle performance e della sicurezza;

- documentazione accessibile e aggiornata.

La gestione delle API non è solo tecnica, ma anche organizzativa e strategica: è ciò che consente alla PA di evolvere verso un modello “as-a-service” (cioè come servizio, che prevede l'ottimizzazione del processo in ottica digitale al fine di offrire un servizio efficiente). Offrire degli ambienti di test (sandbox) agli sviluppatori, come quello messo a disposizione dalla PDND, è una buona pratica che facilita enormemente lo sviluppo di applicazioni interoperabili.

L'interoperabilità moderna si basa su un insieme di tecnologie che rendono i sistemi più flessibili e scalabili:

- microservizi: architettura che suddivide le applicazioni in componenti indipendenti, facilmente integrabili;

- container (es. Docker, Podman, Incus): ambienti leggeri e portabili per eseguire i microservizi;

- orchestrazione (es. Kubernetes, Openshift): gestione automatica del ciclo di vita dei container;

- Intelligenza Artificiale (AI): analizza i dati scambiati per ottimizzare i processi, rilevare anomalie o suggerire azioni.

Queste tecnologie permettono alla PA di costruire ecosistemi digitali dinamici, in cui i servizi, seppur eterogenei, possono evolvere senza compromettere l'interoperabilità.

Nonostante i vantaggi, le interazioni M2M pongono alcune sfide:

- gestione della sicurezza: ogni punto di interconnessione può essere un potenziale vettore di attacco e va quindi gestito con attenzione come indicato nel Modello di interoperabilità e dai documenti adottati da ACN;

- controllo degli accessi: è fondamentale sapere chi può accedere a quali dati e per quali finalità;

- monitoraggio e tracciabilità: occorre registrare ogni scambio per garantire trasparenza e controllo;

- compatibilità tra sistemi legacy e moderni: molte PA utilizzano ancora software datati, difficili da integrare.

Affrontare queste sfide richiede competenze tecniche, ma anche una governance chiara e strumenti condivisi a livello nazionale.

La Piattaforma Digitale Nazionale Dati (PDND)

La Piattaforma Digitale Nazionale Dati (PDND) è il fulcro dell'interoperabilità tra le amministrazioni pubbliche italiane. Gestita da PagoPA S.p.A., la PDND consente lo scambio sicuro, tracciabile e standardizzato di dati tra enti, superando la logica degli accordi bilaterali. Poggia le sue fondamenta sulle relative linee guida redatte da AgID e DTD, adottate da AgID con il parere positivo del Garante della Privacy.

Caratteristiche principali:

- catalogo delle API: ogni ente pubblica le proprie interfacce in un catalogo centralizzato;

- sistema di accreditamento: garantisce che solo enti autorizzati possano accedere ai dati;

- logica “event-driven”: abilita lo scambio automatico di informazioni in tempo reale;

- conformità al GDPR: ogni interazione è tracciata, con logiche di minimizzazione del dato e finalità amministrative esplicite.

La PDND rappresenta un cambio di paradigma: da un modello frammentato a un ecosistema connesso, dove i dati diventano un bene comune, gestito in modo responsabile.

Il Catalogo Nazionale Dati per la Semantica (schema.gov.it)

Per garantire che i dati scambiati siano comprensibili e coerenti, è fondamentale definire un linguaggio comune. Il Catalogo Nazionale Dati raccoglie:

- Vocabolari controllati: elenco di termini/codici predefiniti e approvati che si possono usare per descrivere o classificare informazioni (ad es. classe di Laurea “LM-32” indica univocamente “Laurea Magistrale in Ingegneria Informatica);

- Ontologie: modello formale che descrive un insieme di concetti e le mutue relazioni tra loro (ad es. “Medico” è una “Persona”, che “cura” un'altra “Persona” detto “Paziente”, e che la “cura” è un “Trattamento sanitario”;

- Schemi dati standardizzati: descrizione del formato con cui verranno scambiati i dati, a partire dalle ontologie e dai vocabolari controllati. Per esempio, un'API che ottiene le cure somministrate a un paziente potrebbe restituire una lista di cure, scelte a partire da un vocabolario controllato, ciascuna associata con l'identificativo di una persona che è il medico che l'ha prescritta. In questo modo chi dovrà realizzare un'API simile, potrà basarsi su questo schema. Questo strumento aiuta le PA a descrivere i propri dati in modo uniforme, facilitando l'interoperabilità semantica e l'integrazione tra sistemi.

Oltre alla PDND, esistono strumenti open source e commerciali che supportano la gestione delle API e l'interoperabilità:

- WSO2 API Manager: piattaforma open source per la pubblicazione, gestione e monitoraggio delle API;

- GovWay: gateway open source sviluppato per facilitare l'interoperabilità tra enti pubblici, in linea con le linee guida AgID.

Questi strumenti possono essere integrati con la PDND o utilizzati in contesti locali, sempre nel rispetto del modello nazionale.

Prospettive future e innovazioni emergenti

L'interoperabilità è la base su cui costruire una Pubblica Amministrazione “aumentata”, capace di sfruttare anche l'avvento dell'Intelligenza Artificiale (AI) per migliorare i servizi, anticipare i bisogni dei cittadini e ottimizzare le risorse.

Oltre al cloud e all'AI, altre tecnologie stanno emergendo come potenziali alleate dell'interoperabilità:

- Blockchain: può garantire la tracciabilità e l'immutabilità degli scambi tra enti, utile ad esempio per certificati digitali, registri pubblici o supply chain pubbliche;

- Edge computing: consente di elaborare i dati vicino alla fonte (es. sensori urbani, dispositivi sanitari), riducendo la latenza e migliorando la resilienza;

- Digital twin: modelli virtuali di processi o infrastrutture pubbliche, alimentati da dati interoperabili, per simulare scenari e ottimizzare decisioni, testandole in un ambiente digitale prima di applicarle all'elemento reale.

Iniziative come il Regolamento sull'interoperabilità europea (Interoperable Europe Act) puntano a creare un mercato unico digitale in cui le PA dei diversi Stati membri possano collaborare in modo sicuro e trasparente.

La chiave di volta

L'interoperabilità nel cloud è la vera “chiave di volta” per una Pubblica Amministrazione moderna, efficiente e centrata sui bisogni di cittadini e imprese. Adottando un approccio integrato, collaborativo e conforme alle migliori pratiche nazionali ed europee si potranno costruire servizi pubblici digitali all'avanguardia.

La partecipazione attiva di amministrazioni, fornitori e cittadini è fondamentale per accelerare l'adozione di piattaforme interoperabili, promuovere l'innovazione e garantire un ecosistema digitale sicuro, aperto e inclusivo.

Infine, sta diventando sempre più rilevante il concetto di “interoperabilità tra fornitori di servizi cloud”, che permette di effettuare, ad esempio, la migrazione e il “rehosting” tra piattaforme cloud differenti senza il rischio di incorrere in meccanismi di lock-in oppure di abilitare la comunicazione di servizi e dati residenti su piattaforme cloud diverse, rendendo effettivo il paradigma del multi-cloud oppure su piattaforme “ibride” cloud e on-premises, rendendo effettivo il paradigma dell'hybrid cloud. Grazie a questi approcci si stanno concretizzando soluzioni empiriche di edge computing e business continuity/disaster recovery.

Questo articolo è stato redatto in linea con le più recenti linee guida e strategie nazionali, con l'obiettivo di offrire una panoramica chiara e aggiornata sull'interoperabilità nella PA italiana.

Le immagini presenti in questo articolo sono state sviluppate con il supporto dell'Intelligenza Artificiale, sotto la supervisione del team comunicazione del Dipartimento, con l'obiettivo di rappresentare visivamente i temi trattati.

Questo blog è redatto da Developers Italia

Some rights reserved – Copyright

Some rights reserved – Copyright  Some rights reserved – Copyright Joel Carnat (joel at carnat dot net)

Some rights reserved – Copyright Joel Carnat (joel at carnat dot net)